【明報專訊】人工智能聊天機械人ChatGPT的語言能力令大眾驚訝,你會否擔心無法識別由AI產生的內容?近來學術界大多的討論落於老師和反抄襲軟件能否接招,在功課中找出ChatGPT的蹤影。記者親身測試目前熱門AI偵測工具的效果,並由科大計算機科學與工程學系教授De Kai(吳德愷)拆解背後的運作原理。

AI文章有特點

ChatGPT成為熱話,少不免有學生會用來做功課,有老師嘗試以人類的智慧作出判斷。中大新聞與傳播學院助理教授方可成近日便識破一名學生用ChatGPT做功課,並總括出包括ChatGPT在內的生成型AI產出的文章有以下特點:

1)語氣聽上去非常權威可信,但給出的信息經不起核查;

2)擅長總結評價,但故事和細節欠奉;

3)用不同的詞語重複資料;

4)幾乎沒有任何拼寫和語法錯誤。

該名學生後來承認使用ChatGPT找資料,但強調文章是由自己撰寫。由於大學當時未禁止使用,方可成最終根據文章的質素給予低分。ChatGPT看似強大,但從事AI研究多年的De Kai認為,人類至今仍然有能力辨別與ChatGPT及真人進行的對話,所以並未通過圖靈測試(Turing test )。圖靈測試是指測試者在看不到對方的情况下,分別向人類及機器提問。若經過若干問答後不能區分兩者,則電腦會通過圖靈測試。

要分辨AI生成內容不一定只靠人類大腦,自從ChatGPT去年問世,學術機構、企業及個人積極研發偵測AI的工具。De Kai形容是展開了「貓捉老鼠的遊戲」(Cat and mouse game),一方嘗試提出以AI方式偵測內容是否由ChatGPT產出,而另一方、ChatGPT的研發者很快會說:「我可以騙過它,只需要稍稍修改演算法。」這正是簡化版的機器學習技巧(machine learning),類似「生成對抗網絡」(Generative Adversarial Networks,GANs)的邏輯,以AI鬥AI,推動兩個系統都變得愈來愈強。

偵測工具測得準?

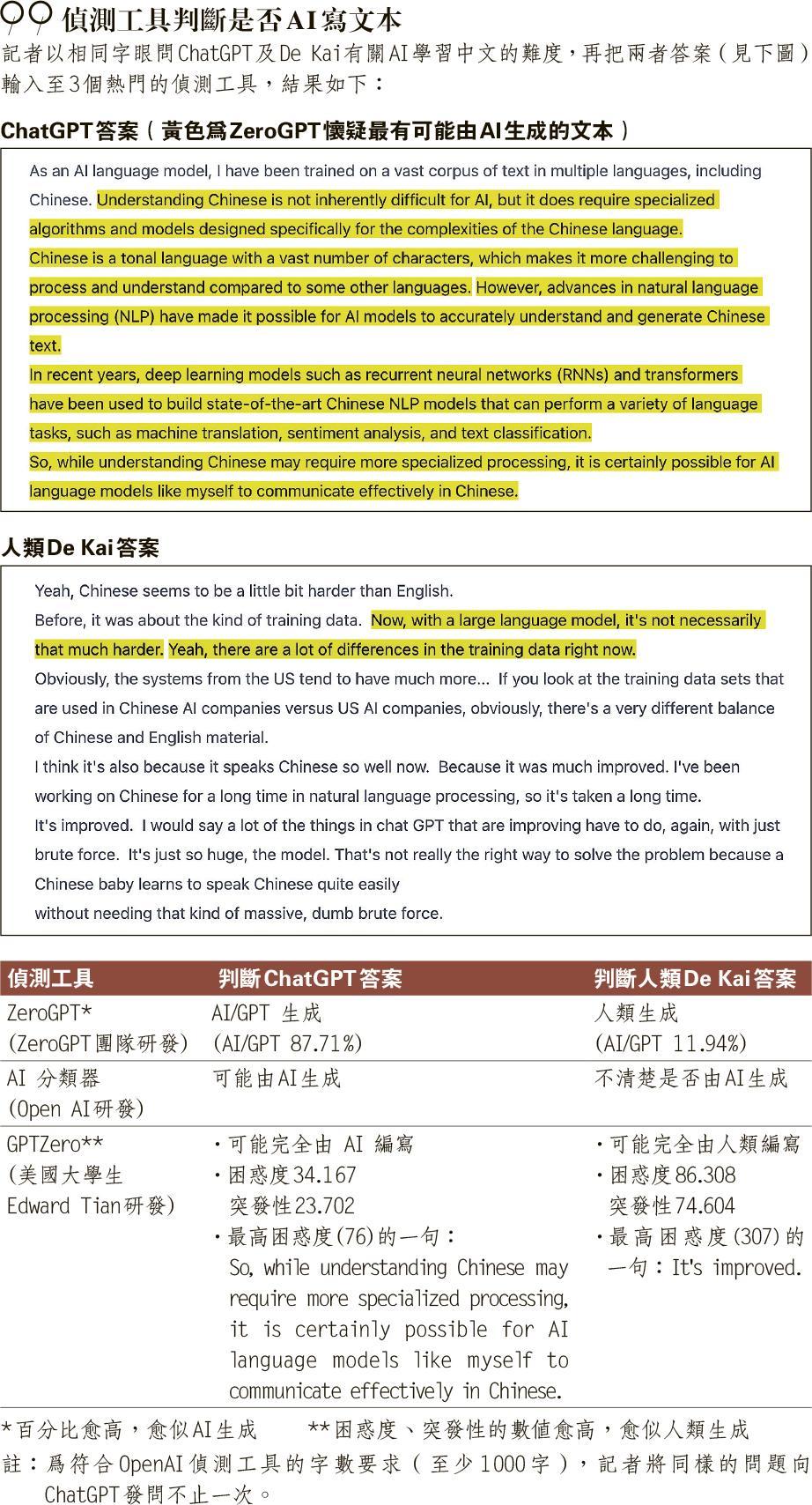

記者嘗試使用網上3款AI偵測工具,看看能否分辨由ChatGPT及De Kai生成的文本(見表)。AI分類器(AI classifier)是由開發ChatGPT的人工智能公司Open AI研發,於今年1月底公開讓大眾免費使用。Open AI強調分類器並不完全可靠,在測試中只能正確識別26%的AI編寫文本,同時錯誤將9%人類編寫文本標記為AI編寫。記者今次測試的結果又如何呢?分類器會把文本分為5級,包括非常不可能、不可能、不清楚、可能及很可能由AI生成。記者輸入ChatGPT生成文本後得出「可能由AI生成」(possibly),而De Kai的答案則列為「不清楚是否由AI生成」(unclear),僅獲評為第三級。

OpenAI的官方網頁指出,研發人員收集大量相信由人類編寫的文本,將其分類為提示訊息(prompt)和回應(response),再利用其他語言模型就提示訊息生成AI的回應。分類器透過同樣主題下的人類文本和AI文本,訓練判斷能力。系統的誤報率刻意維持在較低水平,只有在非常有信心時才會標記為可能由AI編寫。此外,分類器在非英語及字數少(少於1000字)的文本中非常不可靠,亦不能靠它辨認極易預測的文本,例如列出首1000個質數,因為正確答案永遠一致。

AI句子傾向統一整齊

另一個偵測工具「GPTZero」由美國普林斯頓大學四年級生Edward Tian開發,現有超過100萬用戶。系統會為文本的困惑度(perplexity)和突發性(burstiness)評分,De Kai的答案分別獲86.3及74.6分,ChatGPT的答案則獲34.1及23.7分。分數高下立見,GPTZero亦正確將之歸類為人類產出及AI產出。

Edward Tian在Twitter解釋,「困惑度」量度文本對於AI來說有多隨機,數值愈低表示AI對文本非常「熟悉」,換言之更可能是由AI生成;而「突發性」是指人類使用的句子結構變化,AI產生的句子傾向統一整齊,得出的數值會較低。

點解有時九唔搭八?

另一個偵測AI文字的方法是找出「水印」(watermark)。根據報道,OpenAI正在研究為ChatGPT產出的內容加入特殊字眼,即是水印。若想了解其原理,我們要先明白ChatGPT等大型語言模型如何運作。本報去年6月曾專訪De Kai,當時他提到LaMDA與GPT這些語言模型,是從海量數據中選出最有可能切合該語境的答案。今次再度受訪,他詳細解釋語言模型為何可以模仿人類說話。「如果有人說話途中突然停頓,其實很容易預測到下一個……(It's generally pretty predictable what the next……)」De Kai即場玩起接龍遊戲,你又接唔接到落去?訪問時記者用了幾秒反應過來,然後順利接着說「word 詞」、「is 是」。完整句子是:「It's generally pretty predictable what the next "word is". (如果有人說話途中突然停頓,很容易預測下一個『詞是什麼』。)」

人類說話重複又重複

人類語言的確容易預測。「語言模型表現得出奇地好,是因為人類是如此重複和缺乏想像力。我們喜歡認為自己有自由意志、創造力,現實是99%的時間,人們只是在重複別人說過的話。」即使人類的詞彙量大約有10萬至100萬個,但研究發現,你會說出的下一個詞語平均只會有少於兩個選擇。換言之,準確預測的概率並非百萬分之一,而是二分之一。

你可能會問:我並沒有叫ChatGPT接龍,而是提出完整的問題,ChatGPT都答得有紋有路喎。「不,ChatGPT甚至沒有想:『哦,這是一個問題。』它只是問:『最有可能的下一個詞是什麼?』」De Kai強調ChatGPT並沒有信念系統(Belief system),不明白自己在說什麼,亦不懂得分辨正確與錯誤的內容,所以有時連簡單的事實問題都會答錯。

加「水印」調整詞組概率

ChatGPT是以網上資料作為訓練數據,所以它選字的概率會反映人們在該語境下最可能說什麼,亦即是主流意見。不過,由於網上涉及政治、具爭議的議題,可能有相當兩極的意見,De Kai指出ChatGPT在這些內容上更容易出現不準確性。為免爭議,工程師會在系統加入限制或加權。De Kai介紹兩種做法,其一是先過濾訓練數據,使ChatGPT在學習時永遠不會看到有爭議內容;另外亦可在ChatGPT回答用戶前,運行一些安全模塊,阻止不合適或有爭議的內容輸出至用家的屏幕。

語言模型本來是透過分析大量文本,選出最高概率會出現的詞語,但工程師可以故意調整概率以影響選字,亦即是採用水印作偵測工具的原理。美國馬里蘭大學(University of Maryland)的研究人員早前發表文章,提出水印檢測法:在語言模型生成單詞之前,選擇一組隨機的綠色語言標記(green tokens),然後溫和地鼓勵模型從中採用。檢測工具若事先知道特殊列表,就能區分AI生成的文本和人寫的文本,即使在短至25個語言標記的句子都可應用。研究人員認為水印檢測法可以公開讓第三方如社交平台使用,亦可以在語言模型系統中保密地運行。

加入水印對於開發者有什麼好處?De Kai說,從OpenAI的角度,水印可以識別ChatGPT的產物,防止有人當成由自己產出。不過此方法有限制,因為若將ChatGPT的產物加工,放進第二、第三個系統,最終的文本便會愈來愈難看出原先水印,難以辨認。

研減訓練數據量

「這種貓捉老鼠的遊戲將持續一段時間。就個人而言,我認為不久之後,它就不可能被發現了。」此時此刻,De Kai仍然認為ChatGPT非常愚笨,因為它需要取得大量的數據才能運作,「實際上是非常非常低效的學習者(slow learner)」。未來的研發方向會否向語言模型灌輸更多數據?De Kai說其中一部分會走這條路,但亦有人正研究如何大幅降低所需的數據量,訓練出同等智能水平的AI。另一方面,如前文提及目前ChatGPT並不能辨別對錯,所以研究將會在於結合信念系統(Belief system)及語言模型,令AI更加智能。